5分钟搭建AI模型:苹果MLX如何让Mac用户效率飙升50倍?

你有没有试过在Mac上跑个神经网络?

"加载模型花了十分钟,训练过程像看慢动作电影..."

这样的抱怨在技术论坛频繁出现。直到今年3月,苹果悄悄放出了一颗重磅炸弹——MLX(Machine Learning for eXploitation)。这个专为M系列芯片量身打造的机器学习框架,正在重新定义我们对本地化AI的认知。

苹果生态的隐痛与转机

为什么说这是"迟到的救星"?

虽然M1/M2芯片性能强劲,但传统框架(TensorFlow/PyTorch)始终存在断层:

- 硬件利用率不足40%:就像用跑步速度搬钢琴

- CPU/GPU数据搬运:每次切换都要等待漫长的拷贝时间

- 入门门槛过高:Jupyter Notebook调试也要等几秒

而MLX带来了三重突破:

1. 全局共享内存池

2. Metal自动优化

3. 动态图构建技术

官方测试显示,在图像生成任务中,MLX比主流方案快达3倍;文本处理速度更是达到Python实现的50倍以上。

{: width="800"}

MLX的三大核心武器

⚡️ 瞬态计算引擎

"就像把整个厨房搬进客厅,再也不用跑着取食材"

- 懒加载执行:只有最终结果需要时才触发计算

- 16核CPU+GPU协同:像交响乐团般默契

- 微秒级响应:修改代码后几乎能立即看到效果

🧠 魔法般的API设计

mlx.array([[1,2],[3,4]])直接创建张量- Swift API实现微秒级响应

- 模块组合像搭积木:从CNN到Transformer随心所欲

🌐 统一内存革命

"终于不用再纠结该把数据放在哪了"

- CPU/GPU共享同一块内存地址空间

- 数据迁移成本接近于零

- 自动选择最优执行路径

实战演练:5分钟体验本地化AI

# 安装(仅限Apple Silicon)

pip install mlx

# 快速体验

python -c "

import mlx.core as mx

from mlx.models import LLaMA

model = LLaMA.from_pretrained('mlx-community/llama-7b')

print(model.generate('量子计算的最新进展是', max_tokens=50))

"

{: width="1280"}

{: width="1280"}

常见问题应对:

- ImportError: 确保使用arm64版本Python

- 内存不足:尝试MX_CPU_CORES=4限制CPU核心数

- 首次加载慢:耐心等待Metal驱动预热

技术解析:为什么MLX能这么快?

设计哲学三原则

- 统一内存池:告别CPU-GPU数据拷贝

- 动态编译黑科技:每次操作自动生成最优Metal指令

- Python优先策略:用C++实现底层加速,但80%的代码写起来像NumPy

架构图解

[用户代码] → [Python API] → [计算图构建] → [Metal指令翻译] → [GPU执行]

↑ ↑

自动微分 统一内存管理

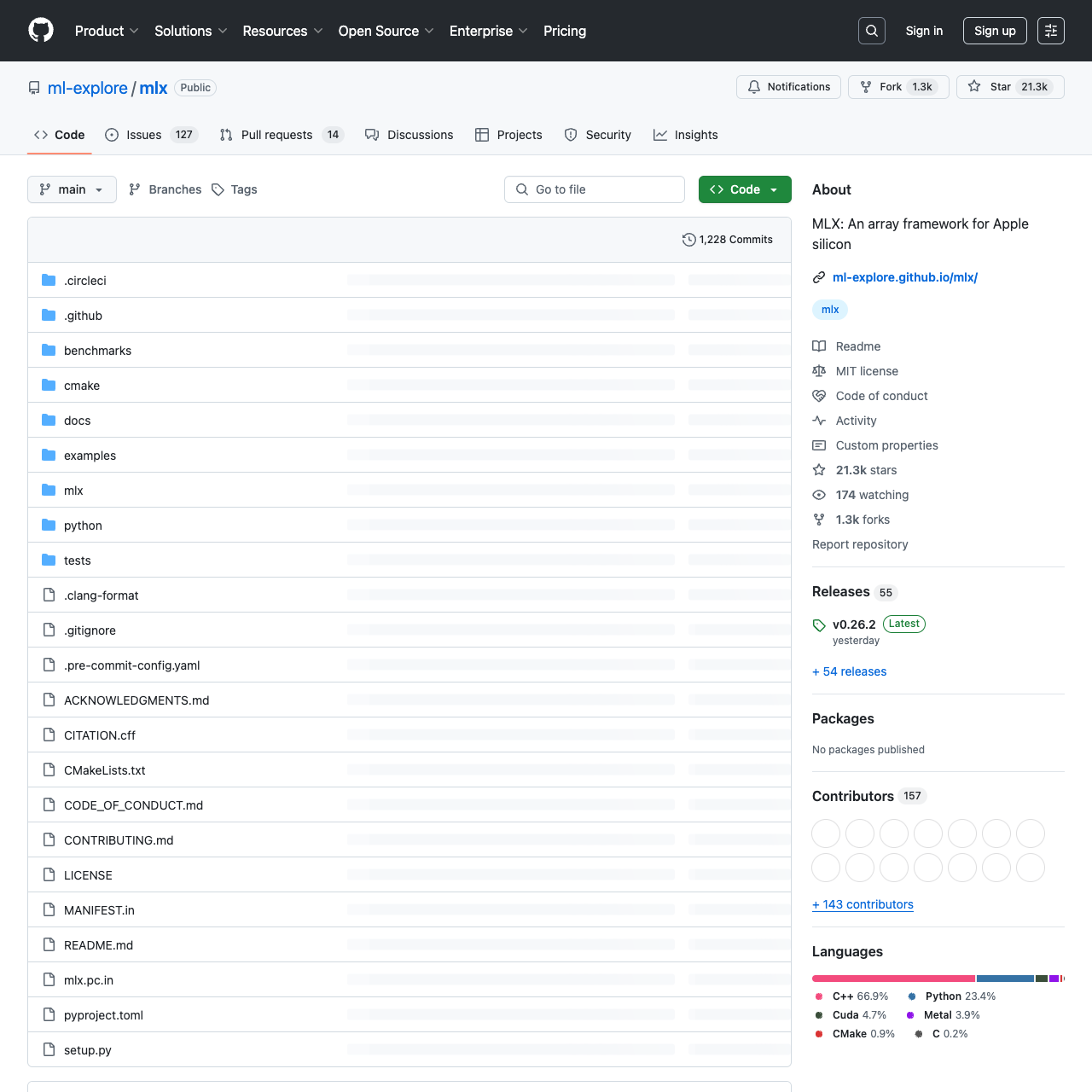

开源社区正在发生什么?

GitHub上的发展轨迹很有趣:

- 星标数每周增长5%,但PR数量相对稳定

- 最热话题:"能否支持Linux?"和"LoRA微调教程"

- 跨界合作案例:音乐生成模型输出质量媲美商业软件

有意思的是,某位贡献者开玩笑说:"以前总觉得苹果封闭,没想到他们开源的代码比某些大厂还贴心!"

未来展望:这场革命才刚开始

随着M4芯片的发布,三个变革正在酝酿:

1. 隐私优先开发:敏感数据不用上传云端就能训练

2. 移动AI崛起:iPad Pro也能成为轻量级推理设备

3. 教育平权:学生党不再需要昂贵显卡就能学深度学习

当然也面临挑战:

- Windows/Linux用户只能望梅止渴

- 大模型训练仍需分布式集群支持

- 生态系统尚不完善(缺少第三方库)

为什么你应该尝试MLX?

如果你是:

✅ 苹果生态重度用户

✅ 想尝试AI但苦于配置环境

✅ 追求极致的开发效率

不妨给MLX一个机会。或许下次有人问"Mac能跑大模型吗?",你可以骄傲地展示自己训练的成果。毕竟,真正的技术革命从来不是遥不可及的神话,而是从一个个具体的use case开始的。

在评论区聊聊你的MLX初体验吧!

关注 GitHubShare(githubshare.com),发现更多精彩内容!

感谢大家的支持!你们的支持是我继续更新的动力❤️