🚀 MLX-LM:在 Apple 芯片上高效运行 LLM 的 Python 开源工具

License

MIT

Stars

2.1k

Forks

237

摘要

MLX-LM 是一款基于 Python 的开源软件,支持在 Apple Silicon 上高效运行和微调大型语言模型。它与 Hugging Face Hub 紧密集成,提供量化、流式生成等功能,适用于多种 AI 场景。

内容

MLX-LM 是一个基于 Python 的开源项目,专为在 Apple Silicon 上运行和微调大型语言模型(LLM)而设计。它结合了 Hugging Face Hub 和 MLX 框架的优势,让开发者可以轻松地使用数千个 LLM,并通过简单的命令进行生成、聊天等操作。

💡 核心功能包括:

- 🌐 与 Hugging Face Hub 集成,只需一条命令即可加载多个 LLM;

- 🔧 支持量化模型并上传至 Hugging Face Hub;

- 📚 提供低秩和全量的微调方式,适用于多种应用场景;

- ⚙️ 分布式推理和训练,提升性能;

- 🔄 流式生成文本,适合实时交互场景。

🛠 使用场景广泛,例如快速实验、脚本开发、程序化集成以及生产环境部署。用户可以通过 pip 或 conda 安装,然后用 `mlx_lm.generate` 或 `mlx_lm.chat` 命令直接开始使用。

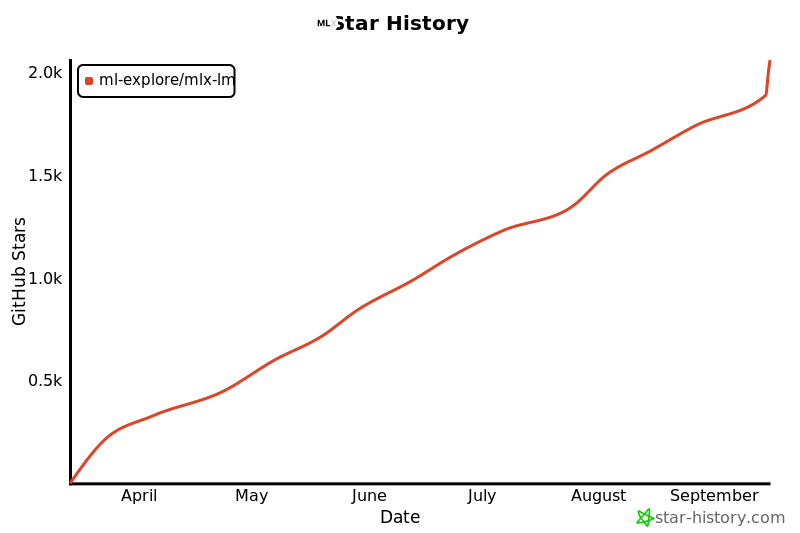

📈 该项目目前拥有 2.1k 个 star 和 237 个 fork,在 GitHub 上表现出不错的热度。随着 Apple Silicon 在 AI 领域的应用增多,MLX-LM 有望吸引更多关注和使用。

💬 社区反馈积极,部分用户已经开始尝试将其用于实际项目中。如果你对 LLM 的本地运行和优化感兴趣,不妨试试这个工具!

关键词

Python 文本生成 LLM

分类

AI应用 自然语言处理 开发者工具

正文到此结束