🚀 TikToken:OpenAI 推出的超高效文本分词神器

License

MIT

Stars

15.4k

Forks

1.2k

摘要

TikToken 是 OpenAI 推出的一款高性能 BPE 分词器,专为 GPT 系列模型打造。它能够快速地将文本转化为模型所需的 token 序列,并提供多种预训练编码方案。凭借其 Rust 实现的核心算法,TikToken 在速度上表现优异,且已在 GitHub 上获得大量关注。本文简要介绍了 TikToken 的功能、应用场景以及为何值得尝试的原因。

内容

TikToken 是 OpenAI 开源的一个高性能 BPE(Byte Pair Encoding)分词器,专为 GPT 系列模型设计。

✨ **功能亮点**

- 它能快速将文本转换为 token 序列,让模型更好地理解和处理语言内容。

- 提供了多种预训练编码方案,如 `cl100k_base`、`p50k_base` 和 `o200k_base`,满足不同模型的需求。

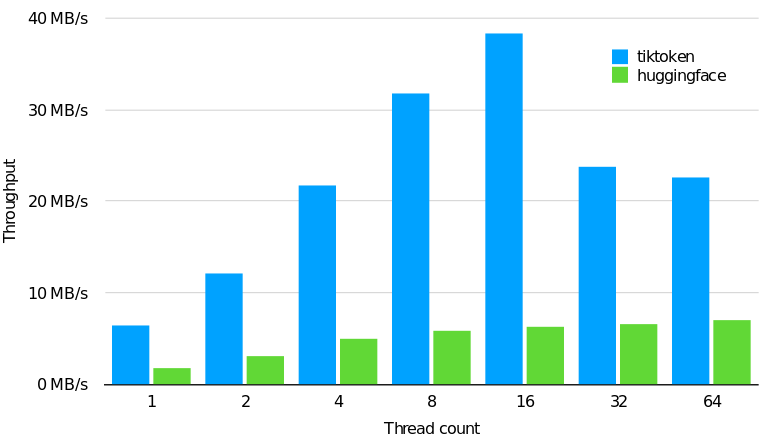

- 通过 Python 或 Rust 编写,结合高效的实现方式,速度比其他开源工具快 3-6 倍。

💡 **使用场景**

- 适用于需要进行大规模文本处理的 NLP 项目。

- 可用于 AI 模型部署中,降低 API 调用成本。

- 适合开发者快速上手,无需复杂配置即可完成任务。

🔥 **性能优势**

- TikToken 的核心算法采用 Rust 实现,显著提升了运行效率。

- 文档清晰,API 设计友好,用户只需几行代码就能开始工作。

- 支持跨平台开发,比如 JS/WASM 绑定,方便在多种环境中集成。

📈 **热度与反馈**

- 在 GitHub 上已获得 13,851 颗星标和 1,200 次 fork,说明其被广泛认可。

- 被多个知名项目引用,例如 awesome-ChatGPT 和 llama_index,进一步巩固其地位。

- 中文技术社区对其热情讨论,不少教程和分析文章都推荐它作为首选工具。

🔧 **扩展性**

- TikToken 提供了灵活的扩展机制,允许用户自定义编码规则。

- 开发者可以通过创建新模块并注册到 tiktoken_ext 来支持自己的编码需求。

📚 **学习资源**

- 包含教育组件,帮助用户理解 BPE 分词原理。

- 提供可视化示例,便于教学和研究。

总之,TikToken 凭借其强大的性能、广泛的适用性和易用性,成为许多 AI 开发者的必备工具。如果你也在寻找一个高效率的分词器,不妨试试看!更多详情可查看 [GitHub 页面](https://github.com/openai/tiktoken) 😄